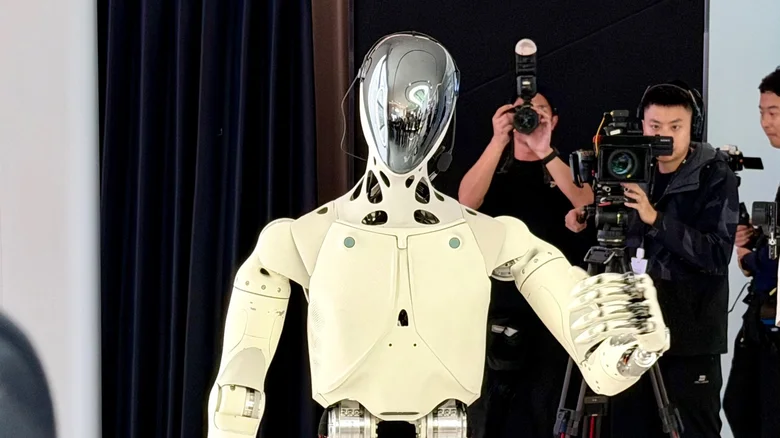

Piața roboților umanoizi evoluează rapid, iar competiția nu mai vizează doar mersul biped, prinderea obiectelor sau autonomia energetică. Un nou front devine tot mai important: modul în care roboții interacționează cu oamenii în situații reale, unde comunicarea nu se reduce la cuvinte, ci include expresii faciale, pauze, ton, privire și context.

- De la empatie „automată” la empatie calibrată: ce propune Angelica Lim

- „Robotul care citește camera”: expresiile faciale ca semnal de feedback

- De ce „empatia excesivă” poate deveni o problemă

- Miza nevăzută: date biometrice, confidențialitate și consimțământ

- Apple, „silent speech” și interesul pentru micro-mișcări faciale

- „Reguli nescrise” pentru mașini: de ce e dificil și ce urmează

În acest peisaj, o direcție de cercetare încearcă să rezolve o problemă aparent simplă, dar dificilă în practică: cum faci un robot să „simtă” că un moment e stânjenitor, că interlocutorul e confuz sau că o glumă nu a avut efect, fără să alunece în mimarea unei empatii exagerate.

De la empatie „automată” la empatie calibrată: ce propune Angelica Lim

Angelica Lim, cercetătoare și cadru universitar la Simon Fraser University, conduce ROSIE Lab (Robots with Social Intelligence and Empathy), un laborator care dezvoltă algoritmi și modele de interacțiune om–robot.

Într-un material video distribuit de CBC și republicat de Yahoo, Lim descrie un obiectiv care contrazice tendința curentă din zona asistenților conversaționali: evitarea „supra-empatizării” ca strategie implicită de a ține utilizatorul cât mai mult în conversație. În viziunea ei, problema nu este empatia ca atare, ci dependența de un tip de empatie standardizată și excesivă, care poate amplifica vulnerabilități, inclusiv în zona sănătății mintale.

Această nuanță devine tot mai relevantă pe măsură ce AI-ul intră în contexte sensibile: suport pentru clienți, educație, îngrijire, asistență pentru persoane vârstnice sau pentru utilizatori care caută validare emoțională.

„Robotul care citește camera”: expresiile faciale ca semnal de feedback

Echipa lui Lim lucrează la algoritmi care analizează expresiile faciale pentru a deduce dacă o reacție a fost pozitivă, neutră sau negativă. În demonstrațiile descrise în material, robotul încearcă o glumă, iar lipsa râsului sau a unei reacții evidente devine un semnal că interacțiunea trebuie ajustată. Ideea nu este ca robotul să „joace teatru”, ci să se adapteze mai realist, într-un mod care reflectă regulile sociale pe care oamenii le folosesc intuitiv.

Cercetarea pornește de la o observație simplă: oamenii se bazează constant pe micro-indicii (privire, zâmbet, rigiditate facială, dezacord exprimat nonverbal) pentru a menține conversația fluidă. Dacă un robot nu le percepe, riscă să fie perceput ca intruziv, insensibil sau, paradoxal, „prea dornic să ajute” fără să înțeleagă cu adevărat situația.

De ce „empatia excesivă” poate deveni o problemă

În ultimul an, discuția despre „personalitatea” modelelor conversaționale a devenit publică: companiile ajustează tonul, stilul și gradul de susținere emoțională al răspunsurilor. Însă critica recurentă este că multe sisteme folosesc empatia ca mecanism de retenție: confirmă, întreabă, mențin dialogul, chiar și când utilizatorul ar avea nevoie mai degrabă de claritate, limite sau recomandări de sprijin profesionist.

Din perspectiva lui Lim, roboții și asistenții AI ar trebui să învețe să fie utili fără să inducă o relație de dependență emoțională. Asta înseamnă, practic, să înțeleagă „când să se oprească”, când să nu valideze automat și când să semnalizeze limitele sistemului.

Miza nevăzută: date biometrice, confidențialitate și consimțământ

Dacă următorul pas pentru roboți este „citirea camerei”, apare inevitabil întrebarea: ce date sunt colectate și cum sunt protejate? Analiza expresiilor faciale și a micro-reacțiilor intră în zona datelor biometrice. În contexte comerciale, astfel de tehnologii pot aluneca ușor dinspre „interacțiune mai naturală” spre „profilare” (de exemplu, detectarea stării emoționale pentru a optimiza vânzarea sau persuasiunea).

De aceea, cercetarea și implementarea au nevoie de reguli clare: transparență (ce se analizează), control (posibilitatea de a opri), minimizare (colectarea strictului necesar) și protecție (stocare și procesare sigură).

Apple, „silent speech” și interesul pentru micro-mișcări faciale

În paralel cu zona academică, industria mare investește agresiv în tehnologii care folosesc semnale faciale și audio. La finalul lunii ianuarie 2026, Apple a anunțat achiziția startup-ului israelian Q.ai, specializat în AI pentru audio și interpretarea „silent speech” (semnale de vorbire fără sunet) inclusiv prin analiza micro-mișcărilor faciale. Valoarea tranzacției nu a fost dezvăluită oficial, dar a fost raportată în presă la aproximativ 1,6 miliarde de dolari sau aproape 2 miliarde, ceea ce ar face-o una dintre cele mai mari achiziții din istoria companiei.

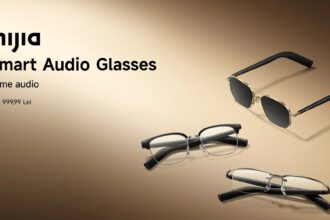

Contextul e relevant: aceeași clasă de tehnologii (interpretarea feței, a semnalelor fine, a intenției) poate alimenta atât interacțiuni mai naturale, cât și produse care operează mai aproape de intimitatea utilizatorului (căști, ochelari inteligenți, dispozitive AR/VR). De aici și presiunea pentru standarde etice și protecții reale.

„Reguli nescrise” pentru mașini: de ce e dificil și ce urmează

Lim descrie o problemă structurală: oamenii urmează reguli sociale pe care rar le pun în cuvinte. Tocmai de aceea, e greu să le transformi în cod. Laboratorul ei încearcă să observe, să modeleze și să testeze aceste reguli în interacțiuni repetate, până când robotul nu mai „ghicește” mecanic, ci se adaptează cu adevărat contextului.

Pe termen scurt, miza practică este creșterea toleranței oamenilor față de roboți în spații publice (recepții, aeroporturi, spitale). Pe termen lung, însă, discuția se mută spre un criteriu mai greu de măsurat: încrederea. Iar încrederea, în interacțiunea cu AI, depinde nu doar de „cât de prietenos” e un sistem, ci și de cât de predictibil, onest și sigur rămâne în timp.